在 C++ 中使用 OpenCV 对图像中的对象进行扭曲透视

例子。代码:#include <opencv2/imgcodecs.hpp>#include <opencv2/highgui.hpp>#include <opencv2/imgproc.hpp>#i

例子。

代码:

#include <opencv2/imgcodecs.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/objdetect.hpp>

#include <iostream>

using namespace cv;

using namespace std;

string PATH = "funk.jpg"; //Image Path

int AREA_FILTER = 1000;

Mat imgOrg, imgProc, imgWarp;

vector<Point> initialPoints, docPoints;

int w = 420, h = 596;

Mat preProcessing(Mat img)

{

cvtColor(img, imgProc, COLOR_BGR2GRAY); // to gray scale

GaussianBlur(imgProc, imgProc, Size(3,3), 3, 0); // blurring for better canny performance

Canny(imgProc, imgProc, 25, 75); // edge detection

Mat kernel = getStructuringElement(MORPH_RECT, Size(3, 3));

dilate(imgProc, imgProc, kernel);

return imgProc;

}

vector<Point> getContours(Mat imgDil){

//detects the biggest rectangle in image

vector<vector<Point>> contours; //vectors example: {{Point(20,30),Point(50,60)},{},{}}

vector<Vec4i> hierarchy;

findContours(imgDil,contours,hierarchy,RETR_EXTERNAL,CHAIN_APPROX_SIMPLE); //finding contours

vector<vector<Point>> conPoly(contours.size());

vector<Rect> boundRect(contours.size());

vector<Point> biggest;

int maxArea=0;

for (int i=0;i<contours.size();i++){

int area = contourArea(contours[i]);

string objectType;

if(area>AREA_FILTER){ //filter small rectangles

float peri = arcLength(contours[i],true);

approxPolyDP(contours[i],conPoly[i],0.02*peri,true);

if(area>maxArea && conPoly[i].size()==4){ //find biggest (4 for rectangle)

maxArea = area;

biggest = {conPoly[i][0],conPoly[i][1],conPoly[i][2],conPoly[i][3]};

}

}

}

return biggest;

}

void drawPoints(vector<Point> points, Scalar color){

for(int i=0;i<points.size();i++)

{

circle(imgOrg,points[i], 5,color,FILLED);

putText(imgOrg, to_string(i),points[i],FONT_HERSHEY_PLAIN,4,color,4);

}

}

vector<Point> reorder(vector<Point> points ){

vector<Point> newPoints;

vector<int> sumPoints, subPoints;

//get corners

for(int i = 0;i<4;i++){

sumPoints.push_back(points[i].x + points[i].y);

subPoints.push_back(points[i].x - points[i].y);

}

newPoints.push_back(points[min_element(sumPoints.begin(),sumPoints.end()) - sumPoints.begin()]);

newPoints.push_back(points[max_element(subPoints.begin(),subPoints.end()) - subPoints.begin()]);

newPoints.push_back(points[min_element(subPoints.begin(),subPoints.end()) - subPoints.begin()]);

newPoints.push_back(points[max_element(sumPoints.begin(),sumPoints.end()) - sumPoints.begin()]);

return newPoints;

}

Mat getWarp(Mat img, vector<Point> points, float w, float h)

{

Point2f src[4] = {points[0],points[1],points[2],points[3]};

Point2f dst[4] = {{0.0f,0.0f},{w,0.0f},{0.0f,h},{w,h}};

Mat matrix = getPerspectiveTransform(src,dst);

warpPerspective(img, imgWarp, matrix, Point(w, h));

return imgWarp;

}

void main() {

//sample

imgOrg = imread(PATH);

resize(imgOrg,imgOrg,Size(),0.5,0.5); // reduce the size of the photo in half

//preprocessing

imgProc = preProcessing(imgOrg);

//get contours

initialPoints = getContours(imgProc);

//drawPoints(initialPoints,Scalar(0,0,255));

docPoints = reorder(initialPoints);

//drawPoints(docPoints,Scalar(0,255,0));

//warp

imgWarp = getWarp(imgOrg, docPoints, w, h);

imshow("Image imgWarp",imgWarp);

waitKey(0);

}

让我们分解代码;

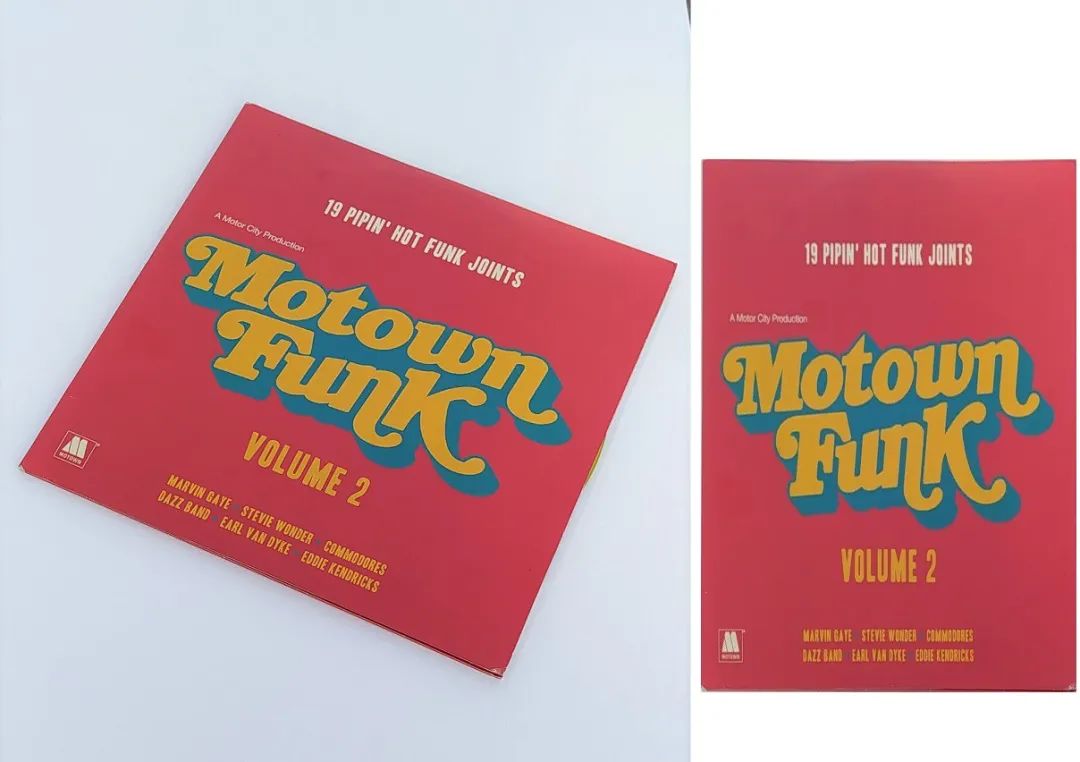

首先我们读取图像文件。然后我们(可选地)减小图像的大小。

string PATH = "funk.jpg"; //Image Path

imgOrg = imread(PATH);

resize(imgOrg,imgOrg,Size(),0.5,0.5);

为了从操作中获得更好的结果,我们首先需要对图像进行一些预处理和转换。我在一个称为预处理的方法中收集了所有这些过程。

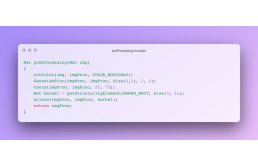

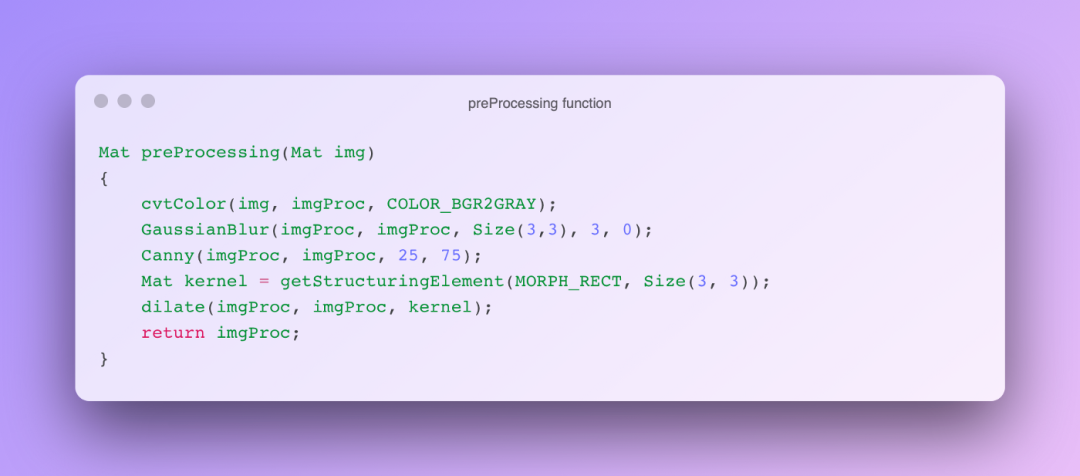

预处理功能

在使用 opencv 时,我们经常将图像转换为灰度。原因是:

· 它减小了尺寸。我们获得了单个通道,而不是 RGB 的三个通道。

· 我们得到更低的复杂性。RGB:10x10x3 像素 = 300 个数据;灰度:我们只有10x10x1 = 100 个输入。

· 许多 Opencv 方法只能在灰度下工作。因此,有必要提前进行转换。

cvtColor(img, imgProc, COLOR_BGR2GRAY);

我们将使用 Canny Edge Detector 来检测角点。它在图像模糊的情况下获得了更好的效果。这个过程称为平滑。边缘检测器内核对噪声非常敏感。因此,始终有必要应用平滑。

Size(3,3):高斯核的大小。

GaussianBlur(imgProc, imgProc, Size(3,3), 3, 0);

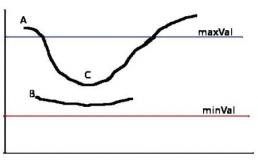

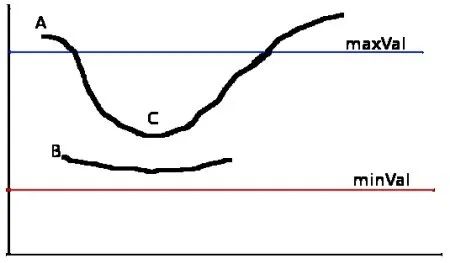

Canny 函数从图像中提取边缘。25 和 75 值是保留在该过程中提取的边缘的阈值。

Canny(imgProc, imgProc, 25, 75);

为形态学操作创建一个矩形内核。

Mat kernel = getStructuringElement(MORPH_RECT, Size(3, 3));

我们将使用膨胀作为形态学操作。膨胀增加了对象的面积,它增加了图像中的白色区域。

dilate(imgProc, imgProc, kernel);

现在让我们获取对象的轮廓;

initialPoints = getContours(imgProc);

在getContour方法中,我们检测将扭曲其透视图并提取其轮廓的对象。

获取轮廓

findContours方法将返回我们的轮廓点。我们需要保留所有找到的点吗?

如果我们传递 CHAIN_APPROX_NONE 参数,那么所有的点都会被保留。但是,我们可以通过消除冗余点来获得存储空间。为此,我们也可以传递 CHAIN_APPROX_SIMPLE。

为了获得外部轮廓,我们通过了 RETR_EXTERNAL

findContours(imgDil,contours,hierarchy,RETR_EXTERNAL,CHAIN_APPROX_SIMPLE); //finding contours

然后,在 for 循环中,我们去除噪声并获取对象。

我们计算每个轮廓的面积。面积必须大于过滤常数;

int area = contourArea(contours[i]);

...

if(area>AREA_FILTER){ //filter small rectangles

我们将在对象周围找到边界框。true表示对象已关闭。

float peri = arcLength(contours[i],true);

我们将找到矩形。

approxPolyDP(contours[i],conPoly[i],0.02*peri,true); if(area>maxArea && conPoly[i].size()==4){ //find biggest (4 for rectangle) maxArea = area; biggest = {conPoly[i][0],conPoly[i][1],conPoly[i][2],conPoly[i][3]}; }

我们得到对象的点;

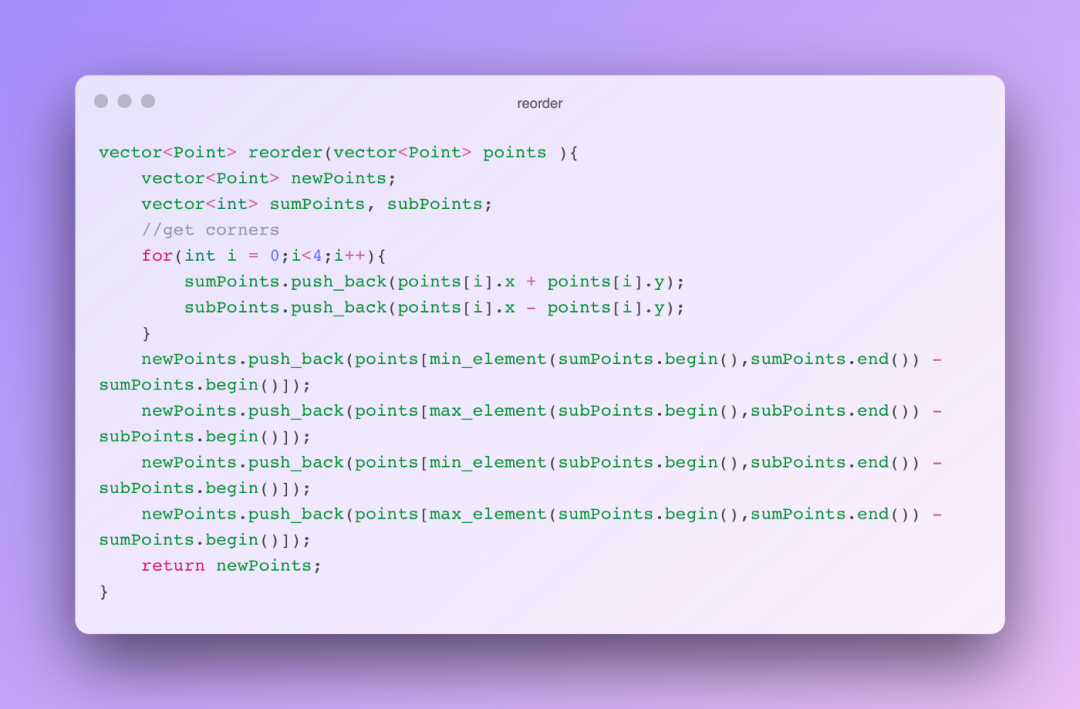

docPoints = reorder(initialPoints);

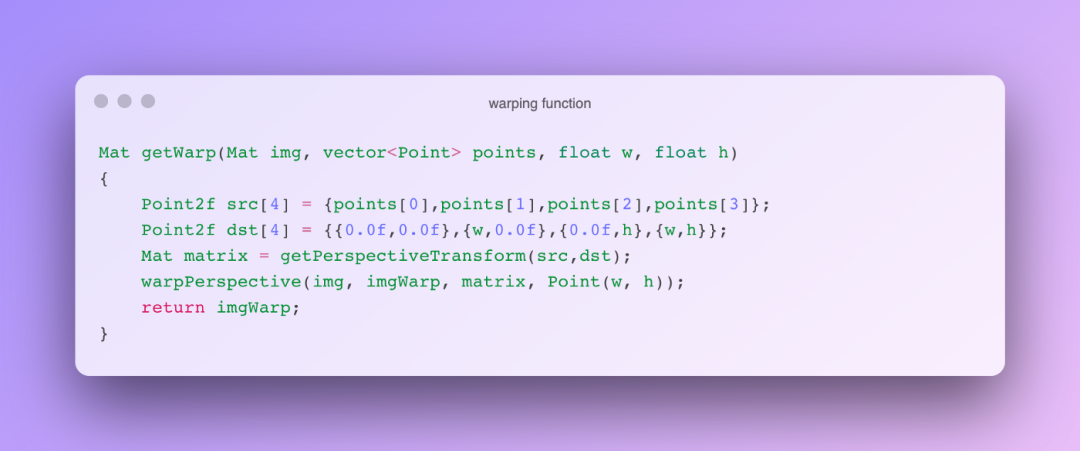

扭曲:

imgWarp = getWarp(imgOrg, docPoints, w, h);

参考

原文标题 : 在 C++ 中使用 OpenCV 对图像中的对象进行扭曲透视