AMD攻入英伟达「大本营」:是游戏,还是AI?

去年年底,AMD 显卡部门的高级副总裁 David Wang 在接受日本媒体采访时谈到了游戏显卡的 AI 问题。David Wang 表示,英伟达在游戏显卡上积极尝试使用 AI 技术,包括在 GPU

去年年底,AMD 显卡部门的高级副总裁 David Wang 在接受日本媒体采访时谈到了游戏显卡的 AI 问题。David Wang 表示,英伟达在游戏显卡上积极尝试使用 AI 技术,包括在 GPU 上就使用了大型 AI 推理加速器,但 AMD 有不同的策略:

「AMD 专注于将 GPU 用于用户需要和关心的地方,以便享受游戏显卡体验,否则用户可能不得不为他们永远用不到的 GPU 功能付费,AMD 相信游戏卡中的 AI 可以而且应该用于让视频游戏更高级、更有趣。」

PC 游戏玩家杜白告诉雷科技,他也认可 David Wang 的说法,「像我这种买回来可能用到报废或者出二手都不会用一次 AI 单元,老黄(英伟达 CEO 黄仁勋)增加了这部分的东西就确实是浪费,单纯为提高售价加进来。」

当然,AMD 也并非全盘否定游戏显卡上 AI 加速能力的价值,问题在于他们认为英伟达把过多的 GPU 资源给了 AI 加速单元,而这部分成本最终还是要由玩家支付,AMD 更希望让游戏卡上的 AI 能直接给游戏带来好处。

英伟达显然不这么看。过去一段时间,ChatGPT 的大火让 AI 行业的发展推向了一个新的高潮,而生成式 AI 恰恰需要基于海量的数据进行推理训练,高算力的 GPU 加速卡自然也成了市场的抢手货。

根据 Fierce Electronics 报道,ChatGPT 目前需要用 25000 块英伟达 A100 GPU 芯片来维持训练。大量公司同样需要基于英伟达的 CUDA 平台进行对 AI 的训练和推理,也包括各类的应用。即便是在消费市场,也有不少人为了生成式 AI 应用而购买显卡。

而在游戏卡的 AI 问题背后,也体现了两家公司游戏业务(游戏卡)和数据中心业务(加速卡)的地位变化。

图/AMD

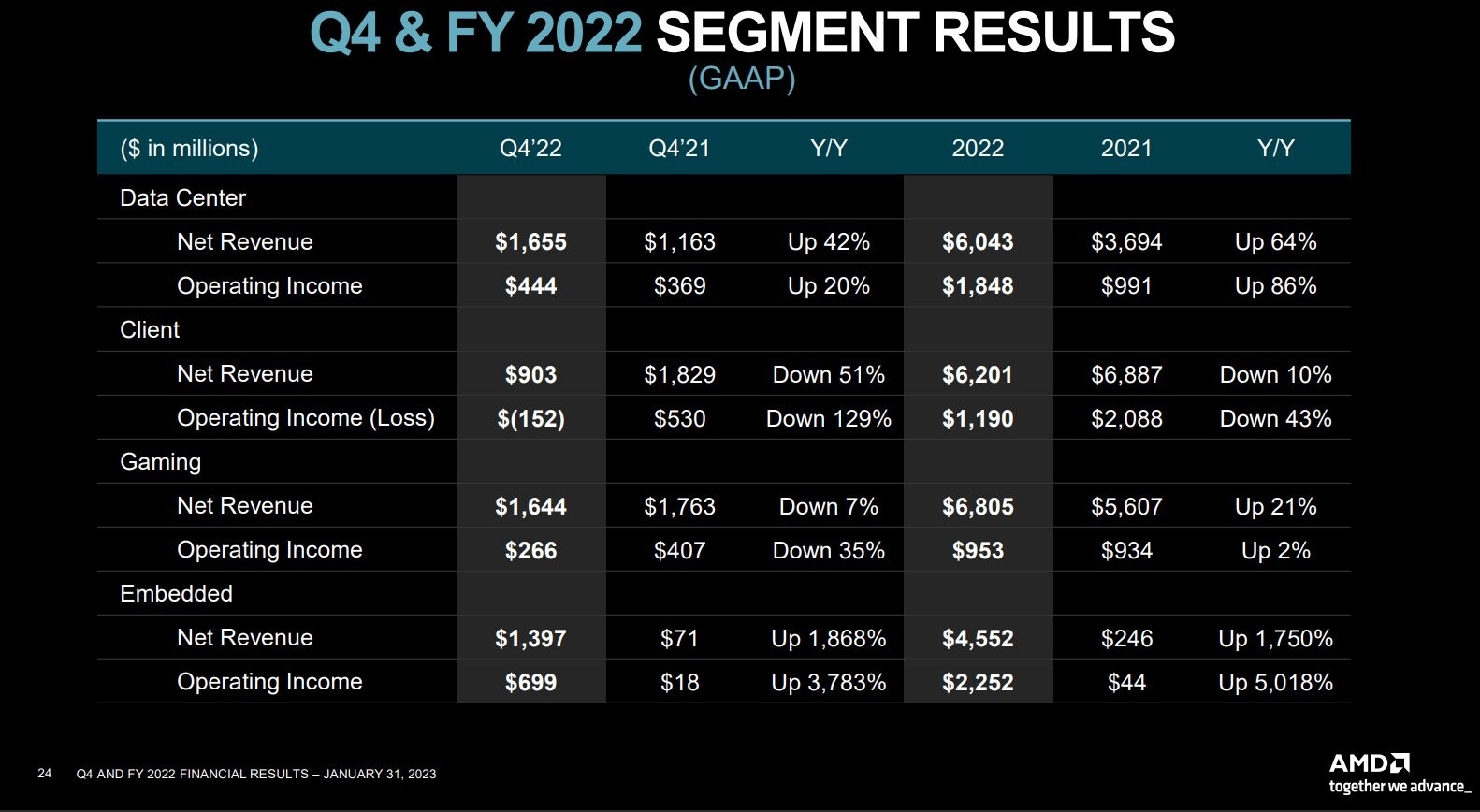

根据财报显示,2022 年 AMD 的游戏业务收入同比增长了 21%,至 68.05 亿美元,反超客户端业务成为 AMD 的第一大业务;相较之下,2022 年(2023 财年)英伟达的游戏业务收入同比减少了近 34 亿美元,下跌 27.2%至 90.67 亿美元,被数据中心业务反超,降至第二大业务。

事实上,英伟达和 AMD 在面对 AI 问题上还有更大的不同。

AI 芯片,各自绽放

去年 8 月底,英伟达和 AMD 旗下的部分 GPU 产品均被美国政府限制对华出售,包括用于数据中心深度学习等场景的英伟达的 A100、H100 以及 AMD 的 MI250。

根据 New Street Research 数据,英伟达占据了可用于机器学习的图形处理器市场的 95%。其中英伟达 A100 是当前最主流的 AI 芯片之一,不仅被海外和国内公司广泛采用,也适合支持当下流行的 ChatGPT、Bing AI 或 Stable Diffusion 等工具的机器学习模型,能够高效地用来训练和使用神经网络模型。

最近流行的 Stable Diffusion 社区,图/Civitai

包括谷歌、OpenAI、特斯拉和 Facebook 等领先的 AI 公司都采用了大量的 A100 以及其他英伟达 GPU,用于 AI 的训练和推理。在国内也有大量公司依赖于英伟达的高端通用 GPU,包括阿里、腾讯、百度等云厂商和浪潮、联想、新华三等服务器厂商都是英伟达的重点客户。

而英伟达在去年发布的 H100,作为 A100 在 AI 行业的替代者,采用了台积电 4nm 工艺,拥有 800 亿个晶体管,支持每秒近 5TB 的外部互联带宽,对于大型 Transformer 模型的训练,英伟达声称 H100 将提供 9 倍于 A100 的性能,过去需要数周时间才能完成的训练可以减少到几天内。

图/英伟达

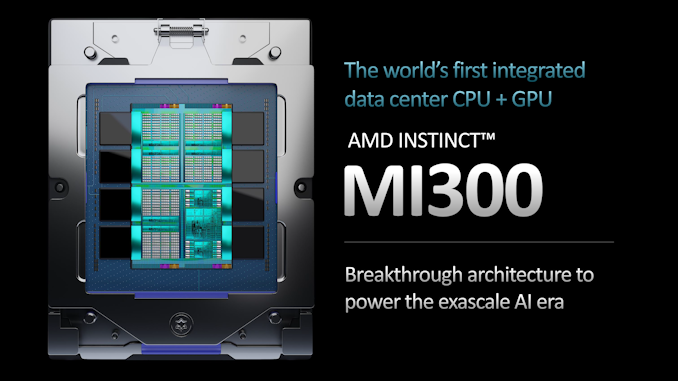

相比之下,AMD 依然更侧重于面向数据中心的 CPU 以及 APU。在 MI250 之后,1 月的 CES 消费电子展上,AMD CEO 苏姿丰正式发布了全球首款面向下一代数据中心的 APU——Instinct MI300。

图/AMD

MI300 APU 芯片集成了 CPU 和 GPU,晶体管数量达到了惊人的 1460 亿个,还包含 128GB 显存 ,主要用于 AI 加速计算。AMD 表示,MI300 可以提供 8 倍于 MI250X 的 AI 训练性能,该芯片可以将推理建模过程的时间从几个月缩短至几周,预计下半年上市。

这种产品倾向上的选择,很大程度上早就做了决定。去年 AMD 主管数据中心业务的副总裁 Forrest Norrod 就指出,英伟达构建了一个丰富的软件生态系统,出色的 AI 加速卡也几乎覆盖了每个市场的需求,AMD 不可能复制英伟达的成功之道。

英伟达的成功之道

英伟达首席科学家戴维·柯克(David Kirk)很早就有一个野心——将主要服务于「游戏」、只做 3D 绘图渲染的 GPU 算力「通用化」,使之转变为通用算力中心。

于是在 2007 年,英伟达正式推出了革命性的 GPU 统一计算平台 CUDA,同时开始基于 CUDA 持续积累算法和软件生态。但英伟达和 CUDA 的成功,还要等到深度学习算法流行之后。

过去 AI 行业普遍依赖 CPU 进行训练识别,谷歌大脑项目创始人、前斯坦福人工智能实验室主任吴恩达在 2010 年曾经为了让 AI 识别出「猫」,就使用了 16000 块 CPU。但在深度学习算法普及之后,AI 需要大量的重复计算,GPU 则因为强大的并行计算能力顺势脱颖而出。而在当时能够高效满足 AI 训练的有且仅有英伟达的 GPU。

到 2011 年谷歌大脑率先将 GPU 应用于深度学习的时候就发现,12 颗英伟达 GPU 提供约等于 2000 块 CPU 的深度学习性能。乘上 AI 和深度学习的大潮,英伟达几乎以一己之力承包了前期企业客户的 AI 计算需求,也正是开始建立属于 CUDA 和英伟达的生态护城河。

自动驾驶公司文远知行技术总监钟华在一次采访回忆称,英伟达推出了 CUDA 以后,相当于把复杂到烧脑的显卡编程包装成了一个简单的接口,造福了广大程序员,现在主流的深度学习框架基本都是基于 CUDA 进行 GPU 并行加速。

A100 线上「厨房」发布会,图/英伟达

即便在面向 AI 的专用芯片流行之后,英伟达 GPU 依然占据 AI 芯片市场的绝对领导地位,不管是 2017 年推出的 V100、2020 年推出的 A100 以及去年推出的 H100,都在进一步完善软件生态和算法积累,时至今日 CUDA 生态已经拥有近 250 万开发者,建立了难以逾越的生态壁垒。

相比苏妈(AMD CEO 苏姿丰)当时还在「收复失地」,老黄至少从七年前就开始为 AI 摇旗呐喊,2016 年英伟达主办的 GTC China 大会上,他就说道:「我们不再是一个半导体公司,而是一个 AI Computing Company(AI 计算公司)。」

此后多年,黄仁勋在不同场合都在对外强调这一点。

AMD 的路线

2021 年 8 月,美国半导体工业协会(SIA)宣布,英伟达 CEO 黄任勋将获得芯片行业的最高荣誉——罗伯特 · 诺伊斯奖,SIA 总裁兼 CEO John Neuffer 在声明中说道:

「黄(仁勋)具有远见卓识和极强的执行力,他促进了芯片行业的发展,颠覆了计算,推动了人工智能。从游戏到科学计算,再到自动驾驶,黄仁勋的成就与无数创新密切相关,他改变了行业和世界。」

今天英伟达已经在面向 AI 的通用 GPU 领域建立了绝对的领导地位,AMD 即便在产品上能有一定的优势,在中短期内都很难弥补生态上的巨大差距。

但毫无疑问的是,AMD 不可能放弃数据中心业务和 AI 加速能力,即便是绕过这个领域深耕游戏芯片市场,终究也会因为在 AI 领域的落后在资金、技术等方面受制于人,反过来又会牵制游戏业务的发展。

AMD 也明白这一点,所以并没有逃避竞争,也没有选择正面的硬碰硬,而是基于自身的 CPU 优势,选择在 APU 上重点发力,与英伟达的拳头产品 A100/H100 形成差异化竞争。对全球第一大 FPGA 厂商赛灵思的收购,一方面也补足 AMD 的 AI 开发和应用生态,获得在 AI 芯片上挑战英伟达的另一种可能。

同时 AMD 也更愿意跟大型数据中心的拥有者——云服务供应商合作,一方面更容易绕开生态上的壁垒,另一方面按照 AMD 的说法,云厂商的计算需求更加简单,加速卡的购买量也足够高。实际上,过去两年超大型数据中心对 AI 芯片的需求不仅没有放缓,反而在加速扩张。

说到底,AI 芯片的竞争还是处在一片正在快速扩张的蓝海之中,随着 AI 应用越来越深入我们的生活,更加难以想象 AI 芯片市场的规模极限,其中留给 AMD 和英伟达的空间自然也足够大。英伟达尽管通过长期积累建立了强大的优势,但还有足够的市场需求等待 AMD 满足,这也是后者的机会所在。

就像 AMD 高管 Forrest Norrod 所说,AMD 不可能复制英伟达的成功之道,但 AMD 仍然可以走出自己的路线。

题图来自英伟达和 AMD

来源:雷科技

原文标题 : AMD攻入英伟达「大本营」:是游戏,还是AI?