AI大模型如此多娇,引得云从科技出门问问竞相融资

AI大模型,如今被公认为是改变未来科技公司、社会发展的先进技术,引得一众科技公司、创业公司关注与押注。在激烈竞争中,已有数家布局该领域的企业企图通过多渠道融资的方式为AI大模型的业务提供资金支持。

AI大模型,如今被公认为是改变未来科技公司、社会发展的先进技术,引得一众科技公司、创业公司关注与押注。在激烈竞争中,已有数家布局该领域的企业企图通过多渠道融资的方式为AI大模型的业务提供资金支持。

文丨阿秋

编辑丨刘备

5月10日,据《AI前哨》消息,有知情人士透露,中国人工智能公司及智能设备制造商出门问问正与中金公司和招银国际合作,为最快可能在年内开展的香港首次公开募股(IPO)做准备,筹资规模或达2亿至3亿美元。4月20日,该公司公开宣布内测探索大模型“序列猴子”。

今年3月底,云从科技定增计划申请获科创板受理,将再次进行募资,定增计划募资资金超36亿元。此次定增计划距离其IPO不满一年,此前其IPO募资总额为17.28亿元。

“这是一个确定性的机会,如果输了,五年最高亏一百亿美金,但要是成了,20年赚一万亿美金。要是你,怎么选?”《经济观察报》报道称,某科技上市公司CTO表示,一家公司即便数据不够多,但有一定的资本、算力技术等资源,“是我,我也会选择做大模型。”

融钱养活AI大模型?

AIGC,即 AI Generated Content,是指利用人工智能技术来生成内容。

2021 年之前,AIGC 生成的主要是文字,而新一代模型可以处理的格式内容包括文字、语音、代码、图像、视频等等。目前主要用在文字、图像、视频、音频、游戏等领域。如今所被广泛应用的 AI 绘画、AI 写作等都属于 AIGC 的分支。

AIGC 技术的基本原理是利用人工智能技术中的“自然语言处理”、“机器学习”、“深度学习”等技术,对大量的语言数据进行分析、学习和模拟,从而实现对自然语言的理解和生成。AIGC 可以称之为 Web 3.0 时代强有力的生产力工具。

自四月至今,出门问问、科大讯飞以及云从科技相继发布了各自的AI大模型,大模型的名称、业务能力以及未来的落地场景各有不同,但从各家财报以及最新的公司动态可以看出,AI大模型是一个费钱的技术,不仅短期对科大讯飞第一季度的业绩造成影响,而且还引得云从科技开启定向募资36亿元,给公司大模型的研发提供资金支持。

出门问问是一家以语音交互和软硬结合为核心的人工智能公司,已陆续推出过AI智能手表、AI真无线智能耳机、智能音箱等智能硬件产品。

4月20日,出门问问宣布内测探索大模型“序列猴子”,但彼时创始人对自己的“序列猴子”打了不及格分,李志飞表示,“如果说ChatGPT-4是100分,我们的模型只有50分,虽然还有差距,但看到了上哈佛的希望。”

5月10日,《AI前哨》报道称,有知情人士表示,出门问问正与中金公司和招银国际合作,为首次股票发行做准备,此次IPO可能会融资2亿美元至3亿美元,最早可能在今年进行IPO。不过,目前IPO考虑还处于初步阶段,融资规模和上市时间等细节可能会改变。

据公开资料显示,出门问问创始人李志飞一直有将出门问问上市的计划。

早在2017年,李志飞曾表示计划两年内寻求IPO,彼时称或许会在美国或香港上市;2018年接受媒体采访时,他又称计划在2019年底或2020年上半年考虑上市;2019年,彭博社引述知情人士消息,出门问问即将获得融资,使其在IPO之前的估值超过10亿美元。该公司正寻求筹集1亿美元资金,并计划在上海证券交易所科创板上市。

但最近李志飞在接受媒体采访时透露,近期并无融资打算,因为公司的商业化做得不错,且自己希望能够花能用1/10的钱,干出比别人10倍好的事情,因为这会让他有成绩感。

与出门问问目前不太差钱的发展状态不同,云从科技从创立至今都未成功脱离亏损的泥潭。

据2022年年报,云从科技2022年营收为5.26亿元,与上年同期相比减幅51.06%;扣除非经常性损益后归属于上市公司股东的净利润为-9.46亿元,上年同期为-7.53亿元,亏损较上年度扩大1.93亿元;经营活动产生的现金流量净额为-6.30亿元,较上年度减少0.7亿元。

谈及各项数据下降原因,云从科技在财报中写明,主要是受宏观经济增速放缓以及市场竞争格局加剧等多重因素影响,收到的政府补助减少,公司项目业务规模下降,以及为增强技术优势,持续进行研发投入所致。

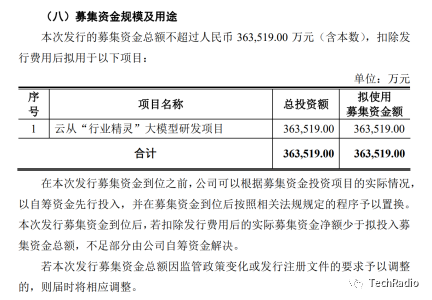

今年3月,云从科技开始向科创板申请定增计划并获得受理,此次将定向融资36亿元,旨为用于云从“行业精灵”大模型研发项目。

图源:《云从科技集团股份有限公司2023 年第一次临时股东大会会议资料》

云从科技表示,公司目前融资渠道相对单一,资金来源主要依靠银行信贷,无法满足公司业务快速发展的需要。公司需要扩充市场化融资渠道,为技术迭代与产品线扩充提供必要的资金支持。本次定向募集资金,有助于增强公司资本实力、缓解公司营运资金压力,提高公司的核心技术竞争力,巩固并提升公司的行业地位,为公司未来经营发展提供有力的保障。

5月6日刚刚对外推出星火大模型的科大讯飞,虽然去年全年利润为正,但投入大模型的研发也在一定程度上拖累了科大讯飞今年第一季度业绩。

科大讯飞2023 年第一季度报告显示,公司 2023 年第一季度营业收入 28.88 亿元,较去年同期下降17.64%;归属于上市公司股东的净利润与扣除非经常性损益的净利润分别为-0.58亿元和-3.38 亿元。

谈及下滑原因,科大讯飞在财报中解释称,面对认知智能技术阶跃带来的重大机遇,公司于 2022年 12 月 15 日启动了“1+N 认知智能大模型专项攻关”,该攻关项目的新增投入一定程度上影响了当期利润,但是会带来公司已有产品竞争力的显著提升。

AI大模型有多费钱?

AI大模型的训练成本、基础设施成本和人才成本,可谓是压在企业头上的三座成本大山。

据国盛证券报告《ChatGPT需要多少算力》估算,GPT-3训练一次的成本约为140万美元,对于一些更大的LLM(大型语言模型),训练成本介于200万美元至1200万美元之间。以ChatGPT在今年1月的独立访客平均数1300万计算,其对应芯片需求为3万多片英伟达A100 GPU,初始投入成本约为8亿美元,每日电费在5万美元左右。

法国里昂商学院人工智能管理学院(AIM)院长、全球商业智能中心(BIC)主任龚业明在接受媒体采访时表示,“大模型的训练和推理成本一直以来是AI产业发展的瓶颈,因此具有大模型构建能力的企业往往是世界科技巨头。这会形成强大的护城河,造成强者恒强的局面。”

行业人士普遍认为,1万颗A100芯片是训练大模型的入门券,但现在厂商面临的问题是买不到芯片,且国产替代芯片在性能和价格上都会大打折扣。此前有媒体报道称,国内拥有超过1万枚GPU的企业不超过5家,且多为英伟达中低性能产品,而拥有1万枚A100芯片的企业最多只有一家。

构建大模型的计算基础设施,不仅是简单的硬件堆砌,更需要实际搭建过程中积累的know-how(实践知识)。

据《每日经济新闻》,阿里云CTO周靖人表示,“所有GPU不是简简单单地堆砌,更需要的是让所有GPU,让异构算力能够联合起来去为我们的模型训练服务。我们有成千上万的模块,如何帮助他们有效地高速连接起来,如何能够提供一个高吞吐、低延迟的网络方案,对模型训练是至关重要的。”此外,完善的大规模的数据存储和低延迟的网络方案同样重要。

原文标题 : AI大模型如此多娇,引得云从科技出门问问竞相融资