AI加速器实现CNN处理速度和降耗

外媒称,瑞萨(Renesas)开发了一种AI加速器,可以高速和低功率执行CNN(卷积神经网络)处理。该声明发布之际,瑞萨正在推动下一代瑞萨嵌入式人工智能(e-AI)的开发,旨在加快终端设备的智能增长。采用该加速器的瑞萨测试芯片实现了8.8 TOPS / W的功率效率,据称这是业界最高级别的功率效率

外媒称,瑞萨(Renesas)开发了一种AI加速器,可以高速和低功率执行CNN(卷积神经网络)处理。该声明发布之际,瑞萨正在推动下一代瑞萨嵌入式人工智能(e-AI)的开发,旨在加快终端设备的智能增长。

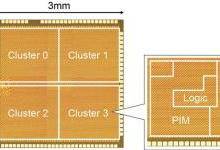

采用该加速器的瑞萨测试芯片实现了8.8 TOPS / W的功率效率,据称这是业界最高级别的功率效率。瑞萨加速器基于存储器内处理(PIM)架构,其中当从该存储器读出数据时,在存储器电路中执行乘法和累加运算。

为了创建新的AI加速器,瑞萨开发了以下三种技术。第一种是三值(-1,0,1)SRAM结构PIM技术,可以执行大规模CNN计算。第二种是应用比较器的SRAM电路,可以以低功率读出存储器数据。第三种是防止由于制造过程中的工艺变化引起的计算错误的技术。总之,这些技术既可以减少深度学习处理中的存储器访问时间,又可以减少乘法和累加运算所需的功率。因此,据瑞萨表示,新的加速器在手写字符识别测试(MNIST)中进行评估时,可实现业界最高的功率效率,同时保持准确率超过99%。

到目前为止,由于二进制(0,1)SRAM结构只能处理值为0或1的数据,因此PIM架构无法通过单比特计算获得足够的大规模CNN计算精度水平。制造方面的变化导致这些计算的可靠性降低,并且需要变通方法。瑞萨现已开发出解决这些问题的技术,并将这些技术作为可以实现未来革命性AI芯片的前沿技术应用于下一代e-AI解决方案,用于可穿戴设备和机器人等应用性能和功率效率。

相关文章

热门网址

AIGC热点

热点

AIGC热点

热点

-

19打开,有戏

时间线

热门标签

热门工具

本站内容源自互联网,如有内容侵犯了你的权益,请联系删除相关内容,联系邮箱:youmao@neone.com.cn

© 2010 - 2024 | 沪ICP备16045468号-5