利用Python网络爬虫获取分类图片

今天来教大家如何使用Python来爬取博海拾贝的图片,分类保存,写入文档。

【一、项目背景】

博海拾贝是一支互联网从业者在线教育的团队,扎根于中国教育行业以及互联网行业的创新和眼球中,打造专业体系化的互联网人在线教育平台。精心创作许多精彩的文章,提供了很多有趣的图片。

今天来教大家如何使用Python来爬取博海拾贝的图片,分类保存,写入文档。

【二、项目目标】

创建一个文件夹, 分类保存所有文章图片。下载成功,结果显示控制台。

【三、项目分析】

1、如何找到真正访问的地址,多网页请求?

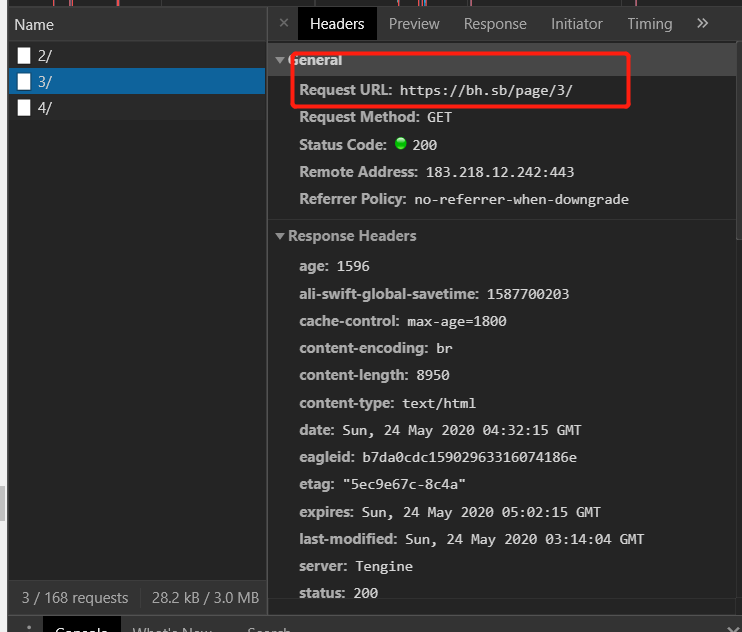

滑动鼠标,观察网站,右键F12 。鼠标滚轮滑动加载新内容。如图:

点开随机网页 , 点开Request URL ,观察网址的规律。

https://bh.sb/page/1/

https://bh.sb/page/2/

https://bh.sb/page/3/

https://bh.sb/page/4/

观察到,每增加一页page/{}/自增加1,用{}代替变换的变量,再用for循环遍历这网址,实现多个网址请求。

2. 反爬处理

1)获取正常的 http请求头,并在requests请求时,设置这些常规的http请求头。

2)使用 fake_useragent ,产生随机的UserAgent进行访问。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

648

1253

1630

1941

1199

有冇SmartoneAI

2020收录工具

13712文章

2M访客

热门网址

AIGC热点

热点

AIGC热点

热点

-

19打开,有戏

时间线

74

323

375

417

热门标签

热门工具

腾讯混元大模型

腾讯研发的大语言模型,具备强大的中文创作能力,复杂语境下的逻辑推理能力,以及可靠的任务执行能力

H2O EvalGPT

H2O.ai推出的基于Elo评级方法的大模型评估系统

像素蛋糕PixCake

简单易用的AI图像精修工具

豆包

字节跳动最新推出的免费AI对话助手

Grok

马斯克旗下xAI推出的人工智能助手

讯飞智文

科大讯飞推出的免费AI PPT生成工具

本站内容源自互联网,如有内容侵犯了你的权益,请联系删除相关内容,联系邮箱:youmao@neone.com.cn

© 2010 - 2024 | 沪ICP备16045468号-5