15秒“虚拟老黄”难辨真假,英伟达Omniverse有多牛?

文/VR陀螺 林德上周,热搜话题#英伟达发布会的黄仁勋是假的#,引起了大众的的激烈讨论。不管是不是知悉英伟达,或是其创始人黄仁勋的网友,无一不被报道中的CG技术所震惊。简单概括一下这件事,有媒体报道称

文/VR陀螺 林德

上周,热搜话题#英伟达发布会的黄仁勋是假的#,引起了大众的的激烈讨论。不管是不是知悉英伟达,或是其创始人黄仁勋的网友,无一不被报道中的CG技术所震惊。

简单概括一下这件事,有媒体报道称,英伟达在上周的SIGGRAPH 2021(计算机图形学顶级年度会议)上发布的官方幕后纪录片中,自曝了今年4月的英伟达发布会上发表演讲的创始人老黄是“假的”,是数字人。

不过随着事情的持续发酵,有网友开始质疑这一消息的真假。

而后根据英伟达的澄清,我们得知,四月份的英伟达发布会上仅有约15秒的镜头是“虚拟老黄”,其余都是黄仁勋真人出境。

四月份英伟达发布会的黄仁勋

虽然只有短短15秒的“虚拟人老黄”,许多人还是被英伟达的CG渲染能力所震惊。真就“以假乱真”,字面意思!

借助8月12日发布的幕后纪录片《Connecting in the Metaverse: The Making of the GTC Keynote》(在元宇宙中连接:GTC主题演讲的制作),我们得以了解到一些这场“出圈”的发布会背后的制作故事。

在纪录片的开头,英伟达的工程师Rev说道,每年的GTC是一个展现英伟达工程师与团队一年成果的绝佳场所。以往的GTC主题演讲都是通过PPT制作演示过程向观众投影,而今年的GTC与先去的发布会不同的是,Rev和他的团队是在英伟达的Omniverse平台中来完成整个主题演讲的创作与渲染。

简单介绍一下,NVIDIA Omniverse是英伟达在2019年正式发布的一个计算机图形与仿真模拟平台,在USD(通用场景描述)的基础上,通过Connector工具将不同软件、工具整合在Omniverse中,能够实现实时协作、加速设计工作流程。

?

?

图源:网络

换句话说,Omniverse允许不同分工的人员在同一时间使用不同软件、工具对同一部设计作品进行编辑处理,并且彼此之间可以实时看到处理进度和效果。这对3D工作者而言,Omniverse的出现带来了极大的便利性。

15秒的虚拟“老黄” 英伟达费了多少工夫

从纪录片中,我们了解到整个GTC主题演讲发布会上的演示,是英伟达和一支小型艺术家团队利用了NVIDIA Omniverse平台上的各种渲染技术,进行3D扫描、动态捕捉、AI合成、画面渲染等制作而成的。

由于疫情的影响,GTC发布会无法像之前一样与观众进行面对面交流,今年的GTC只好以线上发布会的形式召开。经过一番讨论,英伟达团队将厨房主题定为了这次发布会的主题背景。 据了解,整个发布会的厨房布景为CG动画效果。

为了创建黄仁勋家中厨房的3D数字孪生,团队在黄仁勋的厨房里以从各个角度拍摄了数百张照片,通过3D建模软件构建一个粗略的模型,以作为增加建模细节和准确性的起点。

?

图源:postperspective

厨房里的物件大概有6千到8千个,还有成千上万个螺丝钉。可想而知,这个工作量是庞大的。 ?

?

此外,团队还提到,他们在厨房里放了一个乐高版的黄仁勋和带有英伟达发布的软件产品TAO标志的橄榄油罐,作为本次发布会的彩蛋。

纪录片中提到,除了对厨房进行虚拟化,黄仁勋还挑战了“虚拟化自己”,这也就是我们上文说到的,15秒的虚拟黄仁勋。

为了实现这个任务,团队驾驶着有数百个单反相机的大卡车到黄仁勋的家门口,完成第一步,即3D扫描。

为3D扫描拍摄了数千照片的黄仁勋

建模 在有了黄仁勋的模型之后,团队的目标就是让这个模型“活”过来,其中最为主要的两个重点就是模型的面部表现和身体表现。

虚拟黄仁勋的面部表现是由英伟达的Audio2Face技术驱动,可以根据音频来实现面部表现的自动化。

但上图这个模型,在皮肤纹理、灯光等等方面还远达不到“栩栩如生”的状态。因此,英伟达的研究团队通过一项名为Face Video to Video的技术,将拍摄得到的黄仁勋照片映射到CG他自己的CG动画版本上。

“这种技术使我们的CG模型达到一个令人信服的结果。”

合成

经过庞大的工作量,英伟达团队完成了背景和面部表现,不过面部的生动表现仅仅是成功的一半。前文提到,还原老黄最重要的另一个部分是身体表现。

因此在身体表现的部分,英伟达研究团队聘请了一位演员,让他穿上动态捕捉装备,并且记录下该演员模仿黄仁勋演讲的身体姿态。通过名为Audio to Gesture的技术,使得演讲的音频作为身体动作表现的独特传输驱动。

动捕

据悉,该团队一共做了21个版本的“黄仁勋”。研究人员还表示,这21个版本的“黄仁勋”有着不同的性能,在拍板最后决定是使用哪一个时,他还感觉自己是进行选角活动,因为这些“黄仁勋”表现得都很不错。

最后,再通过CG动画渲染技术,才得以实现短短15秒的虚拟“黄仁勋”演示。

渲染

“虚拟老黄”的演示不光骗过了大家,还帮助英伟达在SIGGRAPH 2021上获得了“最佳展示奖”。

Omniverse更新:联手Adobe和Blender 打通元宇宙创作全流程

幕后制作纪录片中,研究人员也提到,Omniverse的想法是将现有的,做3D的各种工具连接在一起,以构建Metaverse。为了满足更多创作者的需求,通过AI简化3D建模,使得3D建模变得更加容易,他们希望每个行业中,都有人在使用Omniverse平台上的工具。

即使Metaverse现在仅仅处于概念阶段,但这样一来,不论是对真实世界的复刻,还是基于Omniverse创造一个完全逼真的3D环境,都将助力Metaverse的形成。

借助此次活动,英伟达的Omnivers平台也得到了进一步进化升级,并宣布将联手Adobe和Blender对Omniverse平台进行重大扩展。

大家都听说过的P图软件Photoshop和视频剪辑软件PR等都隶属于Adobe,Blender则是一个开源的三维动画工具。

Blender现在将支持通用场景描述(USD),使艺术家能够访问Omniverse生产管道。并且,英伟达还推出了实验性的Blender alpha 3.0 USD,其中将包括更高级的USD和材料支持,据悉,将很快为Blender用户提供此功能。

Adobe正在与NVIDIA合作开发Substance 3D插件,该插件将为Omniverse提供Substance材料支持,为Omniverse和Substance 3D用户开启新的材料编辑功能。

此外,英伟达还发布了一个新的Omniverse扩展,GANverse3D – Image2Car,它可以使AI 3D建模变得更加容易。GANverse3D基于一个在2D照片上进行训练的生成模型,合成数千个对象的多视图来预测3D几何、纹理和零件分割标签。

例如下图,在生成的过程中,可以将汽车的单张照片转变成在虚拟场景中的3D模型,并配置有逼真的前灯、闪光灯和车轮。

除新增扩展程序外,英伟达还对一些创意应用程序进行了更新,包括对已推出的August Studio驱动程序、Topaz Sharpen AI、Reallusion Character Creator以及Capture One 21。

英伟达Omniverse开发平台副总裁Richard Kerris曾表示:"英伟达Omniverse通过使Metaverse的愿景成为现实来连接各个世界。根据开发者、合作伙伴和客户的意见,我们正在推进这个革命性的平台,以便从个人到大型企业中的每个人都能与他人合作,建立令人惊叹的虚拟世界,并使其外观、感觉和行为与物理世界一样。"

SIGGRAPH 2021 英伟达推出新显卡RTX A2000

在上周二的SIGGRAPH 2021上,除了揭示了GTC发布会上的CG演示之外,英伟达还带来了一些其他软件及新硬件的更迭消息。

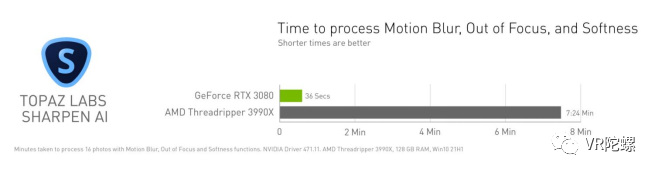

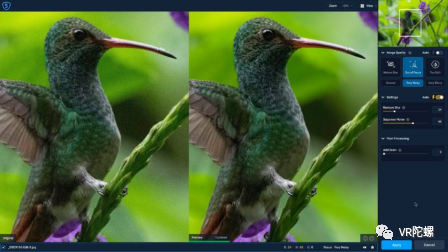

首先,是与Omniverse开发平台全线打通的Topaz Sharpen AI v3.2版本发布。新版本改进了由RTX GPU和Tensor Cores加速的AI模型,增加了1.5倍的运动模糊功能,以进一步减少伪影。

通过实时处理蒙版笔画和覆盖显示的自定义控件,改进了应用内蒙版。

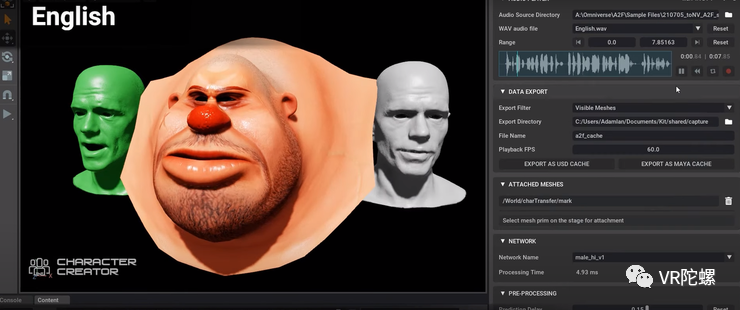

Reallusion Character Creator v4.43是第一个集成Audio2Face的第三方应用程序,现在允许创作者将角色从 Character Creator导出到 Omniverse 作为具有 Audio2Face 兼容的 USD 文件。通过允许面部和唇部动画完全由语音输入作为AI驱动,而不管语言如何,从而简化了3D角色动画的创作过程。

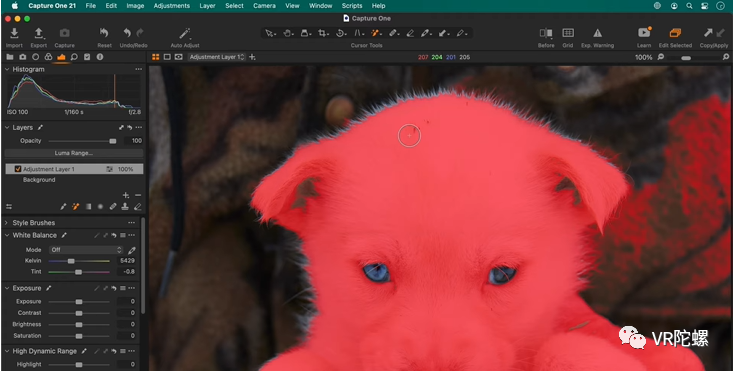

Capture One 21 v14.3.0更新添加了一个新的Magic Brush工具,可以在瞬间根据图像内容创建复杂的蒙版,用于图层编辑,处理底层图像。并且在这个过程中,与CPU相比,使用GPU时速度可提高至多3倍。

在硬件方面,英伟达宣布了新显卡产品RTX A2000,一款低级别的、完全支持RTX的专业显卡。据了解,RTX A2000是一个双插槽、低矮式的显卡,因此将适合2U服务器和较小的桌面机箱。此外,RTX A2000拥有3328个内核,在处理能力和带宽方面几乎与Quadro P5000相当。不过,值得注意的是,RTX A2000的内存仅有6GB。

从性能上来看,RTX A2000介于GeForce 3050TI和3060之间,应该可以满足大多数UHD视频编辑的需求。这款显卡将于10月份开始供货。

以上截图均来源:英伟达