OpenBCI Galea头显体验:神经技术的探索与展望

编译/VR陀螺 万里 几周前,我有幸佩戴使用了搭载顶级硬件的MR头显Vision Pro,它的眼动+手指捏合交互给我留下了深刻的印象。而在Vision Pro

编译/VR陀螺 万里

几周前,我有幸佩戴使用了搭载顶级硬件的MR头显Vision Pro,它的眼动+手指捏合交互给我留下了深刻的印象。而在Vision Pro发布几个月前,我在OpenBCI总部通过它们的Galea头显获得了一种更为狂野的交互体验:

当时我的耳朵夹着高科技夹子、集成了传感器的橡胶模块嵌入我的头发里面、新型面罩贴在我额头前方。就在那一瞬间,我发现可以在VR头显中观察自己的脑电波,并仅凭微小的面部肌肉运动即可移动屏幕前的物体。

目前VR/AR正在稳步发展,不过输入依旧是一大挑战,我们从操作手柄过渡到了手势识别以及眼动追踪,不过在此基础之上,我们又出现了更多新的可能性,比如神经控制。

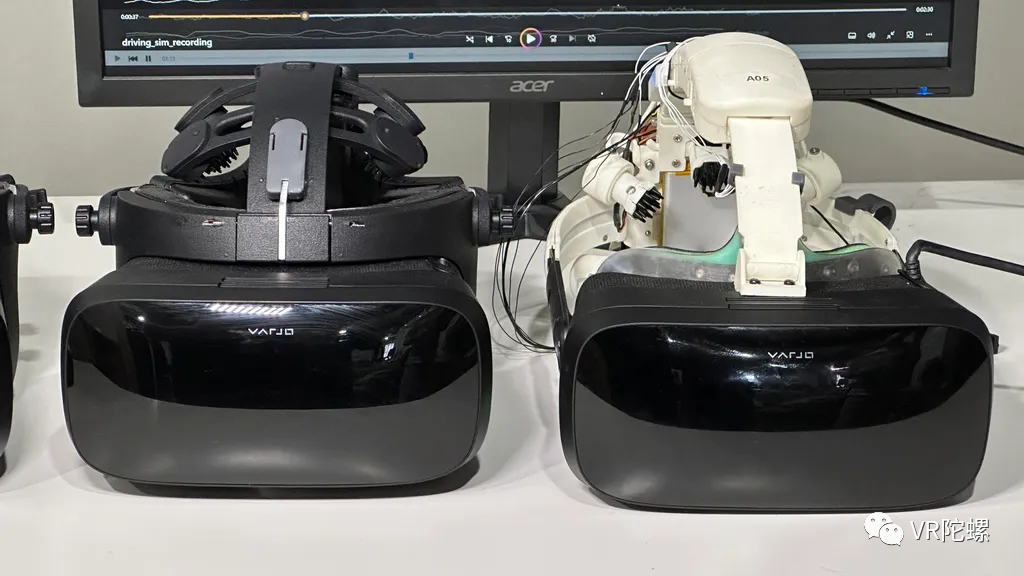

左:Galea最终版本,右:早期头显原型,图源:OpenBCI

密集集成神经传感器,Galea有望在今年上市

OpenBCI是一家总部位于布鲁克林的企业,致力于开发无创脑机接口技术以及工具,OpenBCI一直致力于将感觉系统融入到其MR头显Galea当中,这款头显将于今年晚些时候上市。

我在OpenBCI的办公室上手体验了Galea的原型机,这种感觉非常奇妙,以至于在很多时候我甚至不知道该怎么形容自己的体验。我对于神经技术方面的知识积累也不算多,但是我能感觉到OpenBCI构建的设备以及平台正在探索着技术的前沿并可能对未来有着重要的影响。

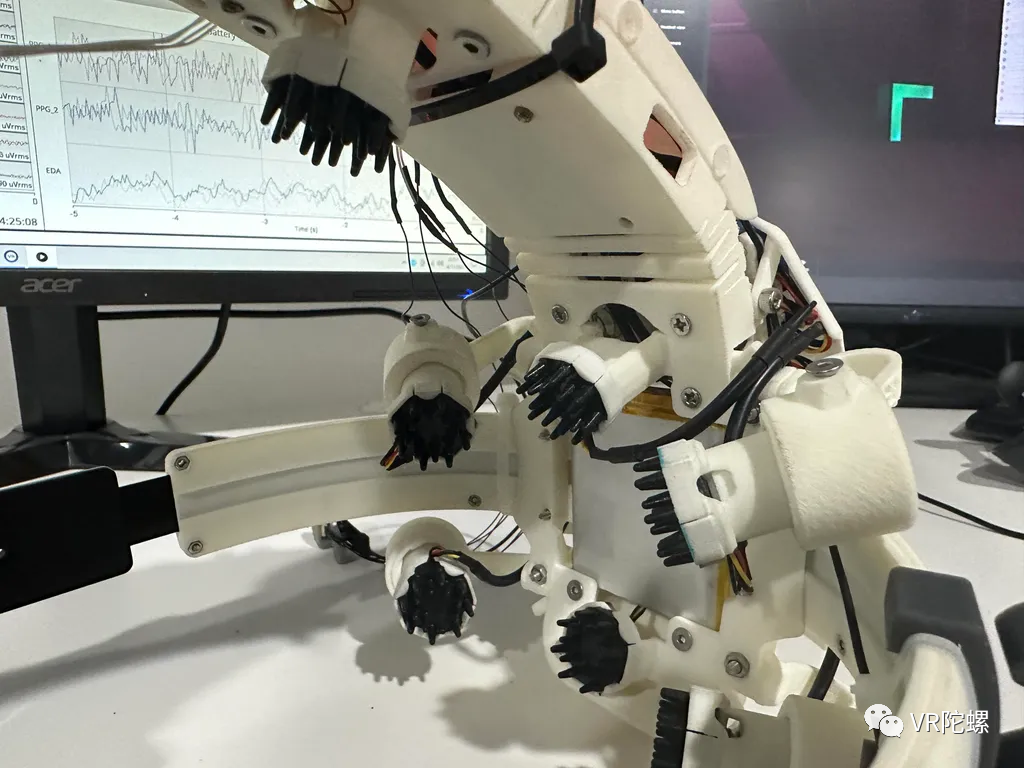

在这之前,我曾体验过一些简单的脑电图传感器集成产品,比如NextMind头带,它可让我通过专注于特定的位置从而触发行动(NextMind去年被Snap收购),它在操作上有点类似于用鼠标点击,但它完全是基于我的想法驱动的。OpenBCI更进一步,在Galea这款设备上集成了EEG、EMG、EDA、PPG和眼动追踪等一系列传感器。

图源:NextMind

EEG(脑电图),它是一种使用电生理指标记录大脑活动的方法。Galea的EEG数据通过它位于后脑勺区域的橡胶头形状的传感器进行测量,这些传感器需要靠近我的头皮工作。(这与NextMind的工作方式类似)传感器在干燥时可以进行工作,不过需要避免过多头发遮挡。

EMG(肌电图),这是一种基于神经网络的肌电信号的数据融合技术研究。在这款头显上,传感器集成在头显的面罩区域,它贴着我的额头、眼睛和脸颊区域。它可以检测我面部的微小肌肉动作。与Quest Pro上面的脸部传感器不同,前者主要是光信号,而这里收集的是电信号。理论上,你可以将动作做得足够小,使其表现得更像是神经脉冲。

目前Meta也在开发适用于腕带设备的EMG技术,早些年Meta CTO Andrew Bosworth曾指出,神经输入技术将会在3-5年内在Meta内部兴起,最终可能与智能眼镜等可穿戴设备相结合。

橡胶头里面配备了一系列EEG传感器,图源:OpenBCI

EDA(皮电反射,或皮肤电活动),一种检测皮肤汗腺活动从而研究对象的心理及压力状态的技术。目前Fitbit在其Fitbit Sense智能手表中也内置了EDA传感器,它用于测量用户压力水平。Galea的EDA传感器则位于头显的前额区域。

PPG(光电容积描记技术),这是一种将光照射到皮肤并测量因血液流动而产生的光散射的方法。该技术在智能手表上已有所应用,可监测心率。Galea在额头区域也配备了PPG,不过,我当时体验的原型产品中使用的是耳夹。

图源:CNET

Galea头显本体是Varjo XR-3,这款头显具有超过70ppd的超高分辨率以及115°FOV,并能提供优质的混合现实体验。这是一款PC VR设备,当然头显上集成的一系列传感器阵列也需要通过连接到电脑以执行数据分析。OpenBCI CEO兼联合创始人Conor Russomanno透露,其传感器阵列不仅能用于Varjo XR-3,也适用于其他VR产品(如价格更低的Varjo Aero等)又或者其他非VR设备。

最近发布的Vision Pro具有强大的运算以及一体化优势,未来它也有可能成为OpenBCI的理想平台。Russomanno还透露,未来开发类似于Vision Pro的AR/VR平台是完全有可能的,他认为苹果这款产品推出意味着苹果对MR计算领域的重要关注,OpenBCI对这一机遇也持有同样的看法。

基于SteamVR平台运行的Galea,图源:CNET

肌肉信号控制运动,加强用户身体机能,Galea开启全新交互方式

OpenBCI的传感器阵列并不试图解决单一目标,而是试图通过系统级的传感器来研究以及打开计算机交互的大门,在体验过程中,它展现了非常多的可能性。

最近,OpenBCI与脊髓性肌肉萎缩症的黑客Christian Beyerlein合作,后者在TED演讲中亲自演示了如何借助OpenBCI的设备来控制无人机。演示时,Beyerlein的双手并没有操作手柄,当他戴上头显后,在不借助外力的情况下,无人机就好像受到了意念控制般能够执行各种飞行指令。这主要是通过设备的EMG传感器所实现的,不过前期需要进行一定的学习以及训练。

图源:TED

我在OpenBCI总部体验了一款名为《Cat Runner》的小游戏,我需要通过面部肌肉的微小动作来控制游戏人物的移动,Galea藏在面罩中的EMG传感器可以很好识别我的这些微小的动作。我去年秋天在Meta Reality Labs也曾体验了类似的基于EMG操作的游戏演示,不过不同之处在于Meta试图在手腕上执行信号采集以及驱动,而Russomanno认为EMG放在头部使用会有更好的机会,因为这些传感器不会干扰头显基于摄像头方案的手部追踪功能。

EMG可以感知微弱的电脉冲信号,以至于设备工作时外人甚至难以察觉到用户的肌肉在运动。不过,传感器、算法、人体输入这三者之间需要花费一定的时间来进行精细调试。由于Galea配备的传感器众多,可以提供大量的数据,这些数据可以用于探索未来的研究方向或新的接口。

除肌肉信号控制以外,OpenBCI的设备还可以提供有关使用VR和AR设备对大脑或注意力影响的反馈。之前也有不少人尝试过使用VR头显的传感器来研究认知过程,比如带有心率传感器的HP Omnicept或一些配备眼动追踪功能的头显等。

在另外一个演示中,我还体验了一款冥想APP。它与一般的VR冥想应用不同,传感器可以检测我不同的脑电波信号并转化为环境光的颜色,也就是说我看到的颜色会随着脑电波信号的改变而改变。我尝试通过集中注意力的方式来改变画面效果,最终发现是有效的(其实我也不太确定)。在这里反馈以及训练和改善我们使用神经冲动控制事物的方式是OpenBCI传感器阵列的关键部分。

左为头显看到的画面,右为传感器阵列实时捕捉的数据,图源:CNET

Russomanno指出,通过EMG,Galea可以扩展Beyerlain的大脑以及更多身体机能。这项演示背后其实揭示了神经反馈将能像AI一样改变我们与计算机的交互方式。

“这并不是说AI没有用,只不过它并非唯一的解决方案,也不是能改变世界的唯一圣杯......我们实际上更喜欢神经反馈以及真正的智能用户界面和智能设计,这是实现循环迭代的另一种方向。利用技术让计算机更好地教导人类是我们将要经历的另一场很酷的革命。”

这个说法让我想起了智能手表的发展脉络:光学心率传感器开始开放数据流,随着时间的推移,手表出现了新的健康功能。如Fitbit在其Sense手表上安装EDA等传感器。伴随着Galea以及类似产品的努力,这可能会进一步为我们打开可穿戴设备的大门,而这些设备最终可以与我们的所见所闻以及双手进行更多交互。

Russomanno对此深信不疑。他认为伴随着苹果等更好的VR和AR头显的到来,将打开通往新输入和外围设备的途径。在我结束演示体验的几个月后,Russomanno通过视频聊天进一步向我解释道,类似于Vision Pro这些具有更强大的AR和MR能力的设备让人瞩目的地方在于它们拥有一系列能感知外部世界的传感器,而OpenBCI所做的是对于用户的内部世界进行探索。“当内外两个数据集结合在一起时,里面可能会产生非常大的可能性。”

Russomanno使用AI与神经反馈进行了比较,我也觉得两者是相互关联的。人工智能需要借助数据集来发挥其魔力,而未来的感官技术系统也同样如此。随着神经技术的发展,AI与之共同进步的可能性也在不断增加。

图源:OpenBCI

结语

OpenBCI的Galea是一款VR和AR头显,但它与Varjo硬件的接口只是其中的一部分,传感器阵列也可以脱离头显单独使用。当我想到未来的可穿戴设备能够与我们身体上的其他设备进行交互联动时,我对此更加感兴趣。如今,更先进的传感器可能会极大增强我们的日常互动。这一切还有很长的路要走,但是我们从Galea等产品身上已经看到了一些良好的开端。

目前,要人们相信VR/AR等可穿戴视觉技术已经很困难了,但是,改进我们最终与空间技术或现实世界的连接方式,可能是VR/AR如何发展成为更有意义的东西(当然也可以说是令人更为不安的东西)的部分答案。个人科技正在试图与我们的感官以及大脑建立更为深层次的联系,但从当前来看,这一切还有待开始。

来源:https://www.cnet.com/tech/computing/i-wore-the-future-of-brain-connected-arvr/?utm_source=reddit.com

原文标题 : OpenBCI Galea头显体验:神经技术的探索与展望