国际巨头角逐AI,谁能触及世界之巅?

想感受最新的科技,只需关注IT领域就够了,因为这里的新技术迭代极快,几乎每天都有创新。而在IT领域,当前最炙手可热的就是人工智能,它正在引领着我们一步步走向“科幻电影”般的未来。国际巨头角逐巨量模型就在本周,微软和英伟达联合发布了Megatron-Turing自然语言生成模型(MT-NLG)

国际巨头角逐巨量模型

就在本周,微软和英伟达联合发布了Megatron-Turing自然语言生成模型(MT-NLG)。其包含5300亿个参数,成为了英文领域最强的巨量模型。

而在两周前,浪潮发布了人工智能巨量模型“源1.0”,它则是中文领域最强的巨量模型。

他们二者都代表了行业内最先进的人工智能巨量模型,也让我们看到国内企业浪潮与微软、英伟达等巨头站在了同一起跑线上。就训练难度而言,中文模型源1.0显然更具挑战。

从OpenAI的GPT-3、到浪潮的源1.0,再到微软和英伟达联合发布Megatron-Turing,可以看到,众多IT巨头们都开始将战略重点转移到角逐人工智能巨量模型领域了。

现在的人工智能模型非常多,几乎所有互联网企业都在做,在搜索引擎上搜索“AI模型”,会有超过3270万条相关结果,足见其火热程度。

那么,为什么很多IT巨头会花费大量精力研究巨量模型呢?

答案很简单,还不是因为一般AI模型“不靠谱”!

AI应用,依然挑战满满

现在很多服务领域的客服系统都用“AI机器人”替代人工了,美其名曰智能化降低运营成本。但实际效果却并没有那么理想。

我们做个简单的测试,在电子商务平台上问客服一些简单问题,“AI”会通过关键词搜索形式来帮你“解答”。如果问题稍微复杂,那么AI就无法理解用户的意思,出现的结果完全就是风马牛不相及,此时则还需人工来受理。这其实就是模型参数不足所造成的。

并且,当前互联网等企业也面临着严重的模型碎片化问题,企业各自为政针对不同领域都训练出了很多小模型,但其真正实战效果却往往仅有最基础的水平。

所以当前亟需的是有一定通用性并且基于海量数据训练的巨量模型,只有这样它才能足够聪明。如果用读书来比喻的话,小模型可能仅有小学生水平,而巨量模型则早已具备教授的知识量了。

源1.0,最强大的中文巨量模型

在巨量模型领域,我们看到很多都是来自国外的模型,以中文为核心的模型少之又少。正如尼采所说,“谁也不能为你建造一座你必须踏着它渡过生命之河的桥,除你自己之外没有人能这么做。”

无论是学术界还是产业界,都需要拥有符合我们国人习惯的中文巨量模型,才能真正让AI实现落地。

正如前文所述,浪潮人工智能研究院发布的全球最大规模人工智能中文巨量模型“源1.0”,再次刷新了多项记录,其单体模型参数量达到了惊人的2457亿。

这个量级大概是个什么概念呢?

当前的“网红”语言模型当属 GPT-3,其在发布之时极具里程碑意义,它的参数量是1750亿个,拥有570GB的英文语料库。而浪潮的源1.0单体模型参数量则比GPT-3还高40%,训练采用的中文数据集达到了5000GB,它总共阅读了大约 2000 亿词,是全球最大的中文数据集,在AI领域也绝对属于巨量型选手。

如果说微软联合英伟达5300亿个参数的Megatron-Turing是业界最大的话,那么源1.0则是中文界巨量模型的魁首。

我们来举个例子,假设人一个月能读十本书,一年读一百本书,读50年,一生所读不过5000本。一本书如果20万字的话,加起来也只有10亿字。源1.0共阅读了大约2000亿词,假如人一年读100本20万字的书,则需要一万年才能读完这2000亿词。

没错,就是一万年,注意这可不是“大话西游”哟!

据了解,源1.0大模型共4095PD(PetaFlop/s-day)的计算量,获得高达2457亿的参数量;相对于GPT-3消耗3640PD计算量得到1750亿参数,源1.0大模型计算效率大幅提升。

而这些计算量的支撑,则是海量的浪潮服务器。众所周知,浪潮AI服务器市占率已位居全球第一,并累计获得56个MLPerf全球AI基准测试冠军,在人工智能领域的专利方面贡献量也位居中国前列。浪潮在AI推理、训练方面能力绝对处于世界领先级。

实战测试,AI水平拿下多个第一

在自然语言理解方面,由于分词方式不同、同一词组不同歧义以及新词汇等方面挑战,所以中文训练的难度更高。

例如分词难点:中国科学技术大学;中国科学技术大学;中国科学技术大学。这三种不同的分词形式,表达的意思有着天壤之别。这还仅仅是其中之一。

因此可以说训练中文NPL要比英文难很多,源1.0的训练难度要比同量级英文模型难度更高。

空谈理论并不务实,只有真正跑起来测试才见真知。源1.0的水平到底如何呢?

其实,它已经刷新了权威中文语言理解测评基准CLUE的零样本学习和小样本学习2项榜单榜首。

zero-shot零样本学习和Few-shot learning 小样本学习在是最能衡量巨量模型智能程度的两项测试,在zero-shot榜单中,源1.0以超越第二名18.3%的绝对优势遥遥领先,在文献分类(CSLDCP)、TNEWS(新闻分类),商品分类(IFLYTEKF)、OCNLIF(原生中文自然语言推理)、成语完型填空(CHIDF)、名词代词关系(CLUEWSCF)6项任务中获得冠军,甚至在成语阅读理解填空(CHIDF)项目中超越人类的水平,成为最强人工智能。

在Few-shot learning榜单中,文献分类(CSLDCP)、商品分类(IFLYTEKF)、文献摘要识别真假(CSLF)、名词代词关系(CLUEWSCF)4项任务中获得冠军。

AI进阶:实现吟诗作赋

我们对人工智能的最大诉求是什么?

当然是“以假乱真”了,更期望的是能够代替人类完成一些具体工作。那么最好的衡量方式依然是图灵测试,也就是通过多轮测试,然后用真人来进行评估,如果人工智能让平均每个参与者做出超过30%的误判,那么这台机器就会被认为具备人类智能了。

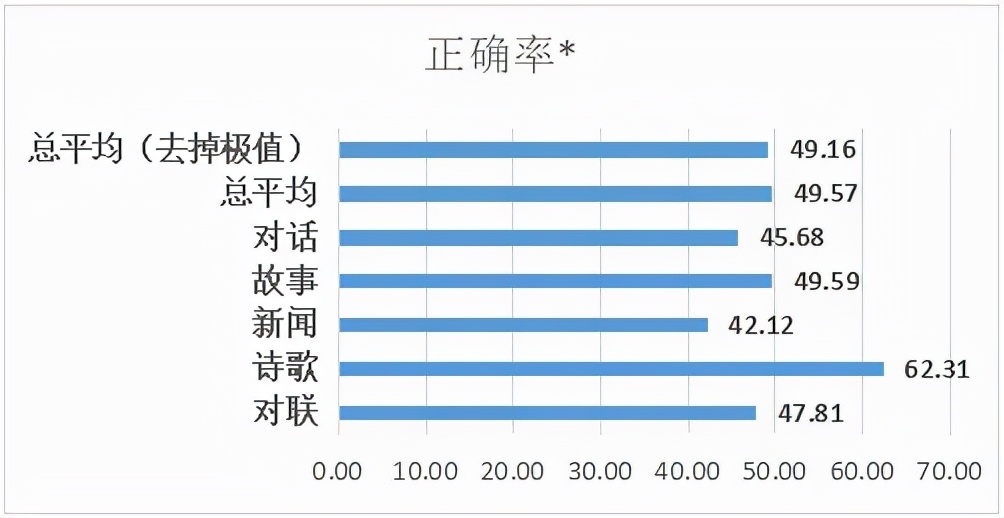

在图灵测试中,源1.0表现出了非凡的“智力”,受访者平均误判率为50.84%,在新闻生成这一领域,误判率更是高达57.88%。有意思的是,将源1.0创作的对话、小说续写、新闻、诗歌、对联,混杂在文学大师的作品中,超50.84%的人不能辨别文学大师的作品和“源1.0”的作品。

接下来我们看看源1.0的作品,对联的上联为:五湖四海皆春色,源1.0所对下联为:三江八荒任我游。

数字对数字,湖对江,海对荒,皆对任,并且念起来朗朗上口,还真看不出是机器所作。

下面一首诗词也是源1.0撰写,战鼓催征千嶂寒,阴阳交会九皋盘。飞军万里浮云外,铁骑丛中明月边。

感受一下,是不是很有古诗的韵味了。让人不禁感叹,这个水平的人工智能真的越来越强大了!

此外,在故事编写及人物对话等方面,源1.0也表现出了惊人的能力。

也就是说,源1.0不仅博学,而且还善用。可以说,既写的了八股文,又能与00后们网聊。通过测试可以发现,源1.0的优势能够广泛应用于人机对话、自助服务、智能办公以及文献智能识别等等领域。

源1.0,打造行业AI催化剂

如此强大的巨量模型,会不会有很高的门槛,让企业高攀不起呢?

据浪潮信息副总裁、浪潮信息AI&HPC产品线总经理刘军介绍,浪潮将会开放源1.0,让学术界和产业界都能够直接使用,极大降低了巨量模型研究和应用的门槛。

学术与产业相结合,给业界呈现出了一个有担当、大格局的浪潮,它不仅在服务器、存储等硬件领域引领行业,而且还在大数据、AI等方面展开新探索,包括此次源1.0的推出。

源1.0对于行业都有哪些帮助呢?据刘军介绍,很多产业都会在源1.0的帮助下产生巨变,例如运营商的智能运维、智能办公场景报告的自动生成、手机互联网用户自动对话的智能助手等等,未来都能够变得更加智能。

正如刘军所说,AI正在飞速进步,浪潮希望有足够的动力快速推动数据、算法和算力这三驾马车,降低AI开发者和行业用户的使用门槛,以更通用的人工智能巨量模型赋能科研创新、公共服务智慧化升级和产业AI化应用,加速人工智能落地,进而构建出一个智慧化的未来。