光子处理器:为 AI 加速,“变革”AI硬件

我们身处于一个数据、信息量爆炸性增长的时代,一个由 AI 引领的、更加智能的时代。但是,持续增加的数据量在为人工智能(AI)提供源源不断的“动力”的同时,也对用于 AI 的电子计算硬件提出了更多的挑战,无论是在计算速度,还是在功耗方面,都已经成为严重制约 AI 发展的主要瓶颈之一

我们身处于一个数据、信息量爆炸性增长的时代,一个由 AI 引领的、更加智能的时代。

但是,持续增加的数据量在为人工智能(AI)提供源源不断的“动力”的同时,也对用于 AI 的电子计算硬件提出了更多的挑战,无论是在计算速度,还是在功耗方面,都已经成为严重制约 AI 发展的主要瓶颈之一。

如今,随着用于自动驾驶汽车和语音识别等机器学习方法的出现,这种数据增加的上升趋势仍将继续下去。所有这些,都给当前的计算机处理器在满足人们需求方面带来了沉重的负担。

好在,一个由多国科学家组成的团队已经开始着手解决这个问题。最新研究进展以“Parallel convolutional processing using an integrated photonic tensor core”为题,于 1 月 6 日发表在顶级科学期刊《自然》(Nature)上。

(来源:Nature)

据论文描述,研究人员开发了一种新的方法和架构,通过使用基于光的处理器或光子处理器,将处理和数据存储结合到单个芯片上。研究结果首次证明,这些设备可以快速并行处理信息,而这种能力是现有电子芯片无法做到的。

研究人员表示,通过这种利用光的独特属性来加速 AI 处理的方式,可能会加速光学计算领域的变革。

新型硬件系统的发展

随着 AI 的兴起,传统的电子计算方法逐渐达到了其性能极限,并且滞后于可处理数据的快速增长。在各种类型的 AI 系统中,人工神经网络由于优异的性能而被广泛应用于 AI 任务,这些网络使用多层相互连接的人工神经网络进行复杂的数学运算。

为了加速人工神经网络的处理,人们已经做出了各种努力来设计和实现特定的电子计算系统。特别值得一提的是,人们在专用集成电路、大脑灵感计算和内存计算等定制芯片的应用上,已经取得了相当大的成功,这些芯片通过一系列称为忆阻器的内存设备直接进行处理。

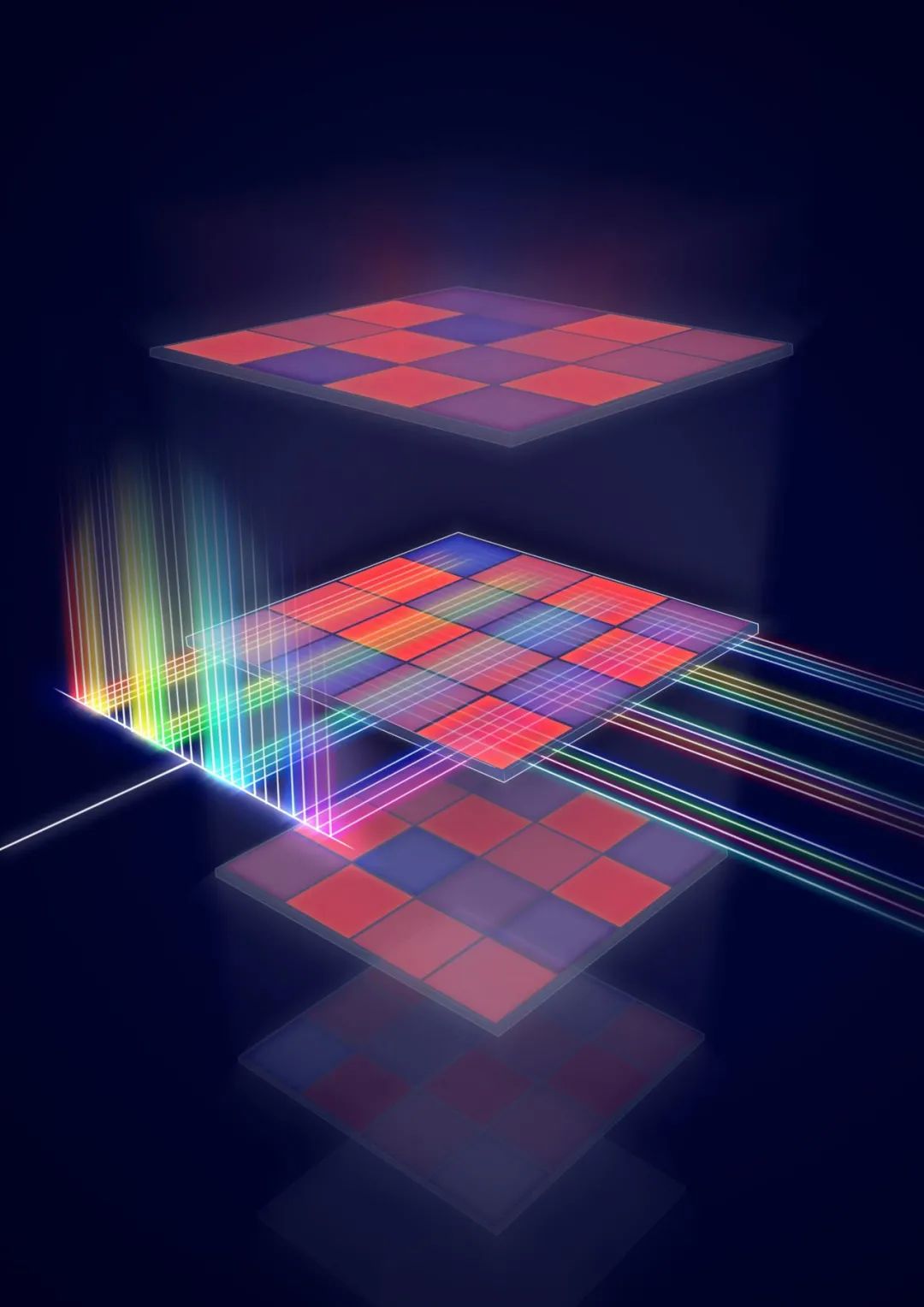

图 | 新型光子处理器的并行卷积处理示意图(来源:牛津大学)

在电子计算中,电子是信息的载体,但一直以来光子都被认为是一种更优的替代选择。因为光谱覆盖的波长范围很广,不同波长的光子可以同时多路复用(并行传输)和调制(通过改变它们可以携带信息),而不会使光信号相互干扰。

这种以光速传播信息的方式能达到目前最小的时间延迟。此外,无源传输有助于实现超低功耗,而相位调制可以轻松调制并检测出频率高于 40 千兆赫的光。

在过去的几十年里,光纤通信取得了巨大的成功。然而,使用光子进行计算仍然具有一定的挑战性,特别是在规模和性能水平上,其与最先进的电子处理器相比更具挑战性。这一困难来自于缺乏合适的并行计算机制、使用材料来允许人工神经元的高速非线性响应以及可扩展的光子器件来集成到计算硬件中。

幸运的是,过去几年来,光学频率梳(Optical Frequency Combs)的发展为集成光子处理器带来了新的机会。光学频率梳是一组光源,其发射光谱由数千或数百万条频率均匀且间隔紧密的清晰谱线组成。这些器件在光谱学、光学时钟计量和电信等领域取得了巨大的成功,其可以集成到计算机芯片中,并用作光学计算的高效能源,非常适合采用波分复用技术(WDM)进行数据并行处理。

光子处理器:为 AI 加速

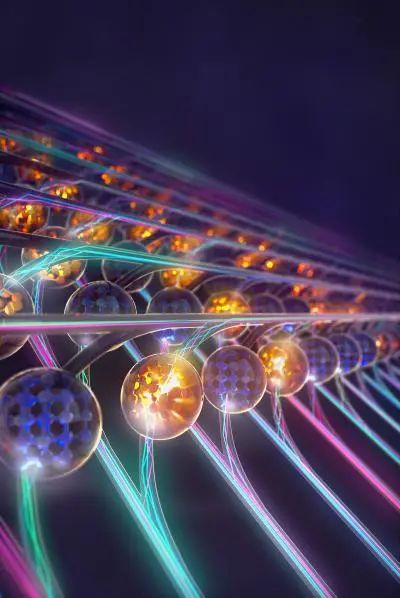

在此次工作中,研究人员成功研制了一个集成光子处理器,该处理器可以对跨越二维空间的光信号进行卷积处理。该设备在基于相变材料(一种可以在非晶相和晶相之间切换的材料)的“内存”计算架构中使用光学频率梳。

通过波长复用,该处理器可以对输入数据进行充分的并行化处理,并利用相变材料的集成单元阵列进行类似的矩阵矢量乘法运算。

(来源:Nature)

该团队也针对矩阵—向量乘法开发了一个硬件加速器。由于不同波长的光不会相互干扰,研究人员可以使用多个波长的光进行并行计算。

为了做到这一点,他们使用了洛桑联邦理工学院(EPFL)开发的另一项创新技术,一种基于芯片的“频率梳”,并以此作为光源。频率梳可以提供各种不同的光波,这些光波在同一个光子芯片中相互独立地处理。

该研究的负责人之一、EPFL 的 Tobias Kippenberg 教授说:“我们的研究首次将频率梳应用于人工神经网络领域。” Kippenberg教授在频率梳发展方面做出开创性的研究工作。

同时,该研究的负责人之一、明斯特大学(WWU)的 Wolfram Pernice 教授也表示:“在机器学习领域,用于加速任务的光子处理器使复杂的数学任务能够以很高的速度和处理量处理,这比依赖电子数据传输的传统芯片快得多。”

在设计和制造完光子芯片后,研究人员在一个可识别手写数字的神经网络上对其进行了测试。这些网络受到生物学的启发,是机器学习领域的一个概念,主要用于图像或音频数据的处理。

论文的第一作者之一 Johannes Feldmann 表示:“输入数据和一个或多个过滤器之间的卷积运算非常适合我们的矩阵体系结构。利用光进行信号传输使处理器能够通过波分多路复用执行并行数据处理,这保证了更高的计算密度,并且仅需一个时间步长就可以进行许多矩阵乘法。与通常在较低频率工作的传统电子设备相比,光调制速度可以达到 50-100GHz 范围。”

牛津大学的 Nathan Youngblood 认为,“利用波分多路复用可以实现更高的数据速率和计算密度,也就是处理器单位面积上的操作,这是以前无法实现的。”

这种高度并行化的框架,有可能在单个步骤中高速处理整个图像。在不久的将来,该系统可以通过使用商业制造程序和辅助现场机器学习来进行大规模扩展。

新型硬件的巨大应用潜力

由于卷积过程涉及到无源传输,所以理论上光子处理核心的计算能以光速和低功耗来进行。这种能力对于能源密集型应用程序非常有价值,比如应用在云计算中。

鉴于传统电子计算方法面临的挑战,集成光子学的出现是令人兴奋的。它作为一个潜在的“接班人”,为未来的计算架构实现前所未有的性能。

然而,建造一个实用的光学计算机仍将需要广泛的跨学科努力和材料科学、光子学、电子学等领域的研究人员之间的合作。

图 | 用于在光照下运行的矩阵乘法处理器的示意图(来源:Oxford University)

尽管报道的光子处理器具有较高的单位面积计算能力和潜在的可扩展性,但全光学计算规模仍然很小。此外,由于存在固有的吸收光的计算元件,以及光电信号经常需要转换,能源效率会受到一些限制。

未来另一个研究方向是,发展先进的非线性集成光子计算架构,而不是单一或二维的线性卷积。

通过将电子电路和数千或数百万个光子处理器集成到一个合适的架构中,一种同时利用光子和电子处理器的混合光电框架,或许在不久的将来可以彻底改变 AI 硬件。未来,这种硬件将在通信、数据中心营运和云计算等领域具有十分重要的应用。