Facebook利用深度学习研究拟真手物交互系统

文/VR陀螺 林德手势识别在VR交互中是一个十分重要的技术,被视为计算机理解人体语言的一种必然方式。自从Ouclus在2019年12月正式推出手势追踪功能之后,手势识别的功能在开发者和用户中受到了很大的欢迎

文/VR陀螺 林德

手势识别在VR交互中是一个十分重要的技术,被视为计算机理解人体语言的一种必然方式。自从Ouclus在2019年12月正式推出手势追踪功能之后,手势识别的功能在开发者和用户中受到了很大的欢迎。但这也是Oculus在收购了手势识别相关的技术公司时隔4年后,才正式推出的手势追踪功能。 可见,手势交互技术还存在技术难度。

虽然手势识别目前仍受到很多的限制,但在虚拟空间模拟现实中与物体的交互行为上,比起技术难度更大、风险更大的“脑机接口”,手势识别显得更加直接自然,因此很多的团队都在持续不断地研究手势识别的计算。

近日,由Facebook虚拟实验室、爱丁堡大学以及香港大学组成的团队发表了他们在手物交互这方面的最新论文成果《ManipNet: Neural Manipulation Synthesis with a Hand-Object Spatial Representation》。虽然目前这项研究成果还处于初步阶段,但从该团队发表的论文的实验数据来看,这一研究的应用将极大提高手物交互的拟真度和灵巧度,使手势识别技术向着全自由交互迈进的一大步。

ManipNet:

基于手-物体的空间表征算法

根据研究,人们每天平均与140个物体互动,并且这些进行交互的日常物品形态是多种多样的。人们通过复杂的手指动作与物体进行交互,但在VR或AR体验中,由于控制器无法产生自然且真实的手部动作,会导致体验沉浸感遭到破坏。想要达到完全的自然沉浸感,关键在于如何基于计算机算法,模拟出人手部自然交互操作上的细微变化。

目前,手势识别的技术主要是通过训练机器学习来实现的,人们自然情况下的手部操作是依靠复杂的手指动作呈现的,如果依靠单纯的数据学习方式学习手的灵巧操作将需要大量的数据。因此鉴于行业内深度学习研究的成功,该团队提出一个名为ManipNet的深度神经网络算法。所谓的深度神经网络是机器学习的一个分支,是通过人工神经网络为架构,对输入资料进行表征学习的算法。

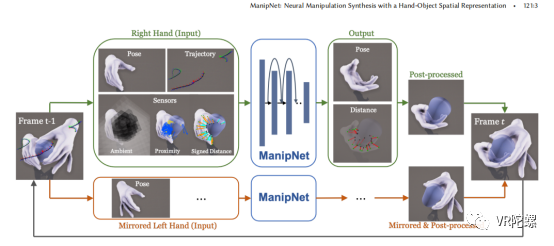

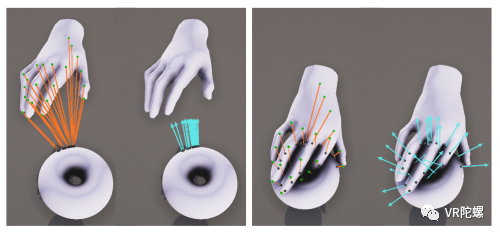

ManipNet是该团队研究人员利用手-物体的空间关系特征,直接从数据中学习手部的自然操作行为的深度学习算法。团队计划通过对有限的物体数据样本的学习扩展到几何变化上。也就是说,通过对小量物体形状的深度学习类推到不同几何变化的物体上。 该团队表示,他们研究的空间表征算法结合了作为体素占比(三维空间分割上的最小单位)的整体物体形状和作为最近距离样本的物体局部的几何细节。这种算法使得深度神经网络可以通过从手腕和物体的输入轨迹中模拟手指运动。

具体来说就是该团队为ManipNet提供了几个时间节点的手指运动轨迹,过去、现在、未来,以及这些轨迹中提取的空间表征,然后深度神经网络会根据这些已有的数据生成一个自回归模型,预测从过去、现在到未来这几个节点之间缺少的其他手指姿态。

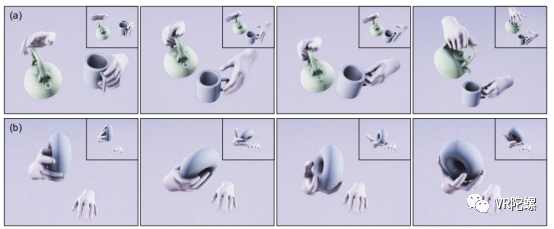

如图1所示,ManipNet是从控制信号和物体几何特征中预测对象操纵的手指姿态,其中控制信号是手腕和物体的6D轨迹,并且该深度神经网络的学习公式需要一个最小的和明确的输入表示,以便实现更好的泛化。

图源:Facebook Research

此外,该团队表示在设计ManipNet时,该算法只处理一个手-物体的“输入”。团队研究人员通过镜像,运行两次该网络,为双手生成预测图像。“这种设计允许我们转换手的空间中的输入特征,使我们能够处理交互作用的手的不同组合。” 该团队还展示了其系统的运行框架概述,如下图所示。其中手腕和物体的运动轨迹、手部的皮肤网格和物体的三维几何图形作为“输入”对象,深度神经网络ManipNet作为自回归模型,会逐帧输出生成手指的详细姿势。

系统框架(图源:Facebook Research)

为了避免ManipNet对训练出现过度拟合的情况导致预测结果偏差较大,同时提高该系统的通用性,该团队利用了三种类型的虚拟传感器来编码物体的几何形以及与手的空间关系。这三个虚拟传感器以粗体素网格捕捉整体物体形状,以点样式捕捉局部几何细节为样本。

图源:Facebook Research

团队对此解释,虽然整体物体特征有助于系统规划整体姿态和预测未来运动轨迹,但物体的局部特征发挥着更加重要的作用——能够使算法拓展到任何几何形状。 该团队还表示,目前通过从少量的物体形和厨具物品种学习,ManipNet已经能够合成各种手指姿态,以抓取更复杂的几何物体。 “我们在本文中开发的具有高通用性的表示法有可能应用于基于DRL的基于物理的对象操作技术。我们提出了一个神经网络公式来合成使用双手操作物体的手指运动,我们的关键贡献是在操纵中代表手和物体之间的空间关系的特征。”

总体看来,该团队在手物交互这一方面做出了以下贡献:

一个基于深度学习的运动合成系统,可以为单/双手的物体操作产生灵巧详细的手指动作;

一种手-物体空间表征的算法,能提高神经网络的通用性;

提供一个手物交互的运动数据集,包括详细的手指运动和16个手-物体的操作运动。

ManipNet或将在VR/AR应用上潜力十足

由于手部活动的灵活度以及因人而异的大小、体积等问题,动画师通常不得不手动设计与捕捉到的全身运动相匹配的手指运动,或者使用单独的设备来产生手指运动。此外,还有数据的可变化性、运动捕捉相机分辨率的提高和追踪手指关节等技术的发展原因,导致当前手物交互方面的研究仍然充满局限性。

该团队在论文中也表示,对物体的灵巧操作是一个相当困难的问题,需要考虑手和物体之间的动态交互,即使通过基于物理基础的模拟,已经开发了操作对象的方法,但这种手-物体操作的开发还有待探索。

即便如此,团队研究人员认为手物交互在游戏和AR/VR实时交互应用中有很大的潜力。

“随着AR/VR硬件在消费者市场的崛起,将我们的系统与其内置对象跟踪相结合为新的互动内容打开了许多创造性的机会。”